La Direction de l’évaluation, de la prospective et de la performance (DEPP) vient de publier un nouveau document de travail. L’objet : comparer les moyennes annuelles de spécialité obtenues en classe et les résultats de l’examen lors de la session 2023 du baccalauréat. Malgré les efforts d’analyse déployés par les auteurs et les subtiles conclusions distillées ici et là, ce document n’est pas exploitable en l’état. Il ne suffit pas de produire de la donnée pour créer une information. Bien mal avisé serait le ministre qui choisirait de s’y référer.

La question de la sous-notation et de la surnotation du contrôle continu

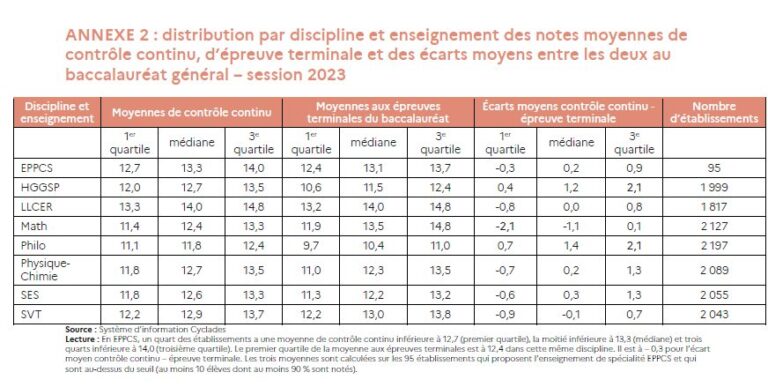

Le rapport collationne plusieurs statistiques entre les résultats des écrits de juin et ce qui est appelé le « contrôle continu ». Cette dernière expression procède d’une curieuse sémantique car justement, les moyennes annuelles obtenues en spécialité n’entrent pas dans le contrôle continu du Baccalauréat. Il aurait sans doute été préférable de trouver une formule qui n’entretienne pas ainsi la confusion. De même, nous sommes plus que circonspects devant les « moyennes d’établissement » affichées. Outre que ces moyennes se transforment sans grande rigueur en médianes dans le tableau, il est assez téméraire de figer une culture d’établissement de la notation. N’importe quelle association de parents d’élèves objectera que pour une même discipline, avec des élèves de niveau comparable, il peut y avoir plus de deux points d’écart de moyenne de classe. Ce n’est pas rien sur des effectifs de 35 élèves. Le lissage général de la « moyenne établissement » n’est donc guère significatif, malgré les assurances formulées par le rapport quant à la « représentativité » des résultats.

Mais avançons.

Nous avons retenu ce tableau de l’annexe 2, le plus apte à résumer l’ensemble :

La DEPP observe qu’hormis en mathématiques, les résultats du contrôle continu sont supérieurs à ceux qui sont observés à l’examen. Et la Direction de se livrer ensuite à une analyse plus précise selon les profils géographiques et socioéconomiques des établissements.

Tout cela est très savant, pour des écarts finalement assez limités, de l’ordre d’1.5 point au maximum.

Mais disons-le, rien ne tient dans le raisonnement.

Une vision déformée de la réalité

D’abord, précision importante, ce ne sont pas les résultats à l’examen qui sont questionnés mais les moyennes annuelles. L’étude part du principe que la « sous-notation » et la « surnotation » ne se mesurent que dans la classe et non à l’examen. Or il est de notoriété publique que plusieurs disciplines ont eu des épreuves très accessibles ces dernières années, loin des attentes du supérieur et même du niveau de difficulté prescrit pour la Terminale. Il est également de notoriété publique que ces mêmes dernières années, les notes ont été remontées automatiquement dans plusieurs académies et que des correcteurs ont fait état de pression pour arriver à des résultats plus élevés. Le baccalauréat ne peut en aucun cas être un étalon de la vérité du niveau des élèves.

En feignant d’ignorer ces manipulations et les différences importantes qui existent d’une spécialité à une autre, les conclusions du tableau sont rendues inexploitables.

C’est le premier contre-sens majeur.

Le pot aux roses aurait pu être découvert si des disciplines comme la NSI, outrageusement généreuse dans sa notation à l’examen, ou HLP, aussi sèche à l’année qu’en juin, avaient été intégrées. Seulement voilà, elles ont été exclues du tableau. La DEPP livre d’ailleurs à ce propos une explication assez laborieuse : les données issues du Livret scolaire ne seraient pas exploitables ! 15% des lycéens sont ainsi purement et simplement éjectés de la statistique (10% pour HLP, 5% pour NSI) et on ne parle que de deux spécialités manquantes. Quatre autres sont aussi absentes (Arts, Biologie-écologie, LLCA, SI). Pour information, la spécialité EPPCS, ce n’est …qu’1% de l’effectif national mais c’est en première ligne du tableau.

Si on avait eu accès aux chiffres 2022 et 2021 dudit document, du temps où les notes à l’examen en SES étaient particulièrement hautes par exemple, tout cela aurait sans doute aussi nuancé les conclusions de l’étude. L’idéal aurait été de pouvoir comparer sur pièces mais le moteur de recherche du ministère ne permet pas de retrouver quoi que ce soit. Que c’est dommage.

Un tableau qui mélange tout

Il est lassant de constater que même au plus haut niveau de l’Éducation nationale, on mélange l’évaluation formative et l’évaluation sommative, c’est-à-dire ce qui relève d’une notation dans un continuum d’apprentissage et celle en fin de la formation. C’est comme si on demandait de comparer la performance de Léon Marchand à la finale du 100m avec le temps moyen de traversée du bassin d’entraînement dans l’année précédente. Que peut démontrer exactement la comparaison ?

Sachant qu’en plus, durant l’année, on ne prépare pas qu’à l’examen. En HGGSP par exemple, nous sommes réglementairement contraints de préparer à l’oral ainsi qu’à la recherche documentaire, deux capacités non évaluées à l’écrit du bac. Nos moyennes ne se limitent pas aux évaluations des deux écrits. Dans son bassin d’entraînement, Léon Marchand prépare aussi au 200m papillon, 200m brasse, 400m quatre nages et ainsi de suite… Il n’est d’ailleurs pas toujours en train d’accumuler les perf’. Il doit forcément s’échauffer sans penser à la montre. Il n’y a donc vraiment aucun sens à comparer le temps moyen annuel de sa longueur dans sa piscine de Toulouse et celle à la Défense Arena pour la médaille olympique.

Enfin, et c’est perceptible en creux de certains commentaires, les enseignants sont visiblement sensibles au contexte local et compensent les difficultés rencontrées par une notation plus généreuse. Cela n’a rien de surprenant, qui plus est à l’ère de Parcoursup. Tout le monde a à cœur de ne pas décourager les classes et de trouver une ligne de flottaison qui permette d’avancer. C’est un effet de la « bienveillance » célébrée hier, remise en cause insidieusement aujourd’hui, semble-t-il.

Est-ce si difficile à comprendre ?

Une étude qui ne pourra donner que de mauvaises idées aux politiques

À quoi sert donc cette étude ? On ne fait pas un tel travail pour rien et certainement pas quand on est dans un ministère. Le document ne précise pas l’origine de son questionnement. Mais quand bien même tout resterait implicite, le ministre qui se saisira de ce rapport sera orienté par l’intention initiale des statisticiens.

Citons un précédent. Il y a de cela une bonne dizaine d’années, on a vu fleurir dans les établissements, pendant les conseils pédagogiques ou autres assemblées plénières, des documents « d’information sur l’ « absentéisme » des enseignants, dans lequel étaient mélangées les absences pour raison de santé, les absences pour formation, les absences pour jury d’examen. Tout cela appelait une conclusion : beaucoup d’heures manquaient à l’appel. En l’état, les tableaux étaient révoltants car ils mettaient tout sur le même plan : des droits d’un côté et la lourdeur organisationnelle de l’Education nationale de l’autre. Des années plus tard, on a fini par supprimer la formation sur le temps de travail des enseignants et par avoir une ministre dénonçant en direct des « paquets d’heures pas sérieusement remplacées ». Il ne suffit donc pas de taire une intention, de se retrancher derrière l’objectivité de la démarche statistique pour présenter un travail neutre.

Tout cela amène une ultime question : que vont donc pouvoir justifier nos décideurs avec ce tableau ?

À peu près toutes les mauvaises idées du moment. Ceux qui pensent aux finances publiques se diront qu’en supprimant l’examen final, les résultats au bac seront meilleurs puisque toutes les disciplines « surnotent » durant l’année. On cumulerait les économies avec les bons résultats éducatifs. Ceux qui se désolent du manque d’ingénieurs se diront que pour attirer les élèves, il faut encore simplifier les programmes et sommer les enseignants de mathématiques d’être encore plus laxistes durant l’année. A minima, tous les cadres pédagogiques trouveront justification à des animations sur la notation et les partisans de la suppression des notes pourront se dire que le lycée est une prochaine cible.

Une étude qui confirme combien les notes ne veulent plus rien dire

Indirectement, le seul mérite de cette étude est de rappeler combien les notes sont de toute façon devenues illisibles. Quand on regarde les écarts entre les établissements ruraux et les « urbain-petite ville » ou « urbain très dense », quand on compare l’IPS, le secteur public/privé, le nombre d’enseignements de spécialités proposés en 1ère, bref tous les critères pris en compte par l’étude, l’aléa est devenu tellement grand qu’il est impossible de mesurer un niveau scolaire.

Tous ceux qui dépouillent en ce moment les dossiers Parcoursup pour les filières sélectives le disent, on ne sait plus comment départager les profils. Oui, un 15/20 dans une discipline ne veut pas dire que l’élève est forcément doué : c’est le cas en anglais par exemple. Oui, un 12/20 dans tel autre établissement réputé est en réalité un résultat tout à fait prometteur. On pourrait multiplier encore les exemples.

On savait que le baccalauréat était démonétisé mais si le contrôle continu est à ce point fragilisé, cette situation signifie que nous ne sommes plus collectivement en capacité de certifier quoi que ce soit.

À rebours de la multiplication des évaluations nationales, des documents de cadrage sur la notation (nos « propositions d’échelle descriptive simple »), des « réunions d’entente » entre correcteurs, des « concertations des équipes pédagogiques », des « plans locaux d’évaluation » en vigueur depuis trois ans, le système est à l’agonie. Il serait temps de pointer les vrais problèmes : l’incapacité de coordonner un examen national de telle sorte que l’horizon de difficulté soit équivalent d’une discipline à l’autre, l’incapacité de fournir un cadre réellement prescripteur sur ce qu’est la notation, en spécialité mais également en tronc commun, l’incapacité à assumer la cohérence d’une politique éducative.

Ci-gît la réforme du lycée de 2019.