IA générative et géopolitique ou le projet Stargate de Donald Trump pour dominer le monde. Il y a quelques jours l’annonce a fait l’effet d’une bombe. 500 milliards de dollars. L’Amérique allait tout écraser. La pauvre Europe, sans parler de la France, ne seront pas de taille. La cause semble entendue en ce mois de janvier qui voit le 47è président des États-Unis s’installer avec fracas à la Maison Blanche.

Oui mais voilà. L’IA ça va vite. Très vite.

Sommes-nous face à un moment « Spoutnik » ? Quels sont les impacts géopolitiques, les enjeux perceptibles ?

Je propose de prendre un peu de temps pour faire le point sur ces questions. Le flot d’information qui nous submerge est d’autant plus difficile à absorber que dans le domaine de la tech, de l’IA, tout va vite, très très vite. Nous venons ici de passer en une semaine de l’écrasement du match par Donald Trump avec Stargate, à un tremblement de terre provoqué par une baleine chinoise qui vient de faire aussi bien, avec nettement moins d’argent, que la puissance censée tout écraser sur son passage, en attendant de récupérer le Groenland et le canal de Panama.

Ces pistes de réflexions peuvent servir en HGGSP, avec le thème sur la Connaissance en Terminale, ou les enjeux de puissance en Première. Mais de façon générale elles peuvent, je l’espère, nourrir toutes les réflexions des personnes intéressées par ces questions.

IA générative et géopolitique : quels sont les principaux enjeux ?

À grands traits il est possible de proposer quelques axes simples.

La régulation comme socle de réflexion

Les approches des différents acteurs sont multiples, opposées et leur durée de vie peut être extrêmement variable.

EUA : l’approche est assez fragmentée. L’initiative l’AI Executive Order de Biden aurait pu servir de trame et nécessiter une petite présentation. En travaillant sur cet article j’avais prévu de le faire. Oui mais voilà, Donald Trump est (déjà) passé par là en révoquant purement et simplement ce texte qui devait encadrer un minimum le développement des IATrump revokes Biden executive order on addressing AI risks, By David Shepardson. Demeurent des régulations sectorielles, mais surtout l’influence des Big Tech sur le cadre législatif.

Du côté de l’UE la situation est nettement plus … touffue.

L’Union européenne (UE) a adopté une approche proactive en matière de régulation de l’intelligence artificielle (IA) AI Act – European Commission, cherchant à équilibrer l’innovation technologique avec la protection des droits fondamentaux et des valeurs sociétales AI Regulation – European Parliament.

Voici les principales composantes de la stratégie européenne en matière de régulation de l’IA :

Le Règlement sur l’intelligence artificielle (AI Act)

Le AI Act de l’UE, adopté en 2021 et entré en vigueur en 2024, constitue la pierre angulaire de la régulation de l’IA en Europe. Ce règlement vise à garantir que les systèmes d’IA utilisés dans l’UE respectent des standards éthiques et de sécurité élevés. Il repose sur une approche fondée sur les risques, avec des exigences plus strictes pour les applications d’IA considérées comme « à haut risque ».

On y retrouve principalement trois axes :

- Classification des risques : Les systèmes d’IA sont classés selon trois niveaux de risque : faible, élevé et inacceptable. Les systèmes à risque élevé (comme ceux utilisés dans la santé, la sécurité, la justice pénale) sont soumis à des exigences strictes en matière de transparence, de sécurité, de traçabilité et de gouvernance.

- Surveillance des algorithmes : Des mécanismes de surveillance et d’audit seront mis en place pour garantir que les systèmes d’IA respectent les principes éthiques de transparence, non-discrimination et responsabilité.

- Interdiction des systèmes d’IA à risque inacceptable : Certaines applications d’IA, comme celles utilisées pour la surveillance de masse en temps réel, sont interdites, en raison des menaces qu’elles font peser sur la liberté et la vie privée.

L’UE met l’accent sur l’intégration de principes éthiques dans la régulation de l’IA. En 2019, elle a adopté des Lignes directrices éthiques pour une IA digne de confiance, qui précisent que l’IA doit être transparente, explicable, non discriminatoire et respectueuse des droits fondamentaux des citoyens. Ces lignes directrices sont destinées à guider les entreprises et les États membres dans le développement de technologies d’IA responsables et équitables.

La loi sur la gouvernance des données (Data Governance Act)

La régulation des données est également un enjeu clé pour l’UE, car l’IA repose sur l’accès et l’analyse de grandes quantités de données. La Loi sur la gouvernance des données, entrée en vigueur en 2022, vise à encourager le partage de données tout en garantissant la protection de la vie privée. Elle prévoit la création d’infrastructures de données ouvertes et sécurisées, ce qui permet de développer des systèmes d’IA plus performants tout en respectant les normes européennes de protection des données (notamment le Règlement général sur la protection des données, RGPD).

L’approche à l’égard de la gouvernance mondiale de l’IA

L’UE plaide également pour une régulation mondiale de l’IA, en partenariat avec d’autres acteurs internationaux comme les États-Unis, la Chine et des organisations multilatérales. L’objectif est de promouvoir des normes communes pour éviter une « course aux armements technologiques » et garantir que l’IA soit utilisée dans des conditions éthiques et responsables.

Le problème de cette approche multilatérale, c’est qu’elle semble complètement à côté des réalités géopolitiques actuelles. Donald Trump, en révoquant l’AI Executive Order de Joe Biden a envoyé un message clair à ce propos. Alors avec qui collaborer ? La Russie ?

Concernant Moscou tout est limpide : peu de régulation formelle, focus sur l’utilisation militaire et informationnelle. IA utilisée dans la surveillance et la manipulation de l’informationVoir à ce sujet l’excellent article de Yannick Harrel et Thierry Berthier dans la revue Diplomatie, Grand Dossier 81, disponible en ligne ici : L’intelligence artificielle, un vecteur de souveraineté pour la Russie.

Heureusement, il reste la Chine !

La Chine adopte une approche centralisée pour réguler l’intelligence artificielle (IA), visant à équilibrer l’innovation technologique avec le contrôle étatique et la promotion des valeurs socialistes.

Ainsi en août 2023, la Chine a mis en place une réglementation spécifique pour les contenus générés par l’IA. Ce cadre impose aux développeurs d’IA de soumettre leurs modèles à une approbation gouvernementale avant leur déploiement public. Les systèmes doivent adhérer aux « valeurs socialistes fondamentales » et éviter la diffusion de contenus pouvant porter atteinte à la sécurité nationale ou à l’ordre public. Cette régulation vise à encadrer des technologies telles que les chatbots et les générateurs d’images, en assurant une conformité avec les directives étatiquesContenus générés par l’IA : cette nouvelle réglementation instaurée en Chine.

Les faits font sans doute du mal aux défenseurs du multilatéralisme mais ils sont là : dans le domaine de l’IA, de la course enclenchée, il semble difficile à ce jour d’espérer une réelle collaboration pour encadrer les développements de ces outils, en dehors de l’espace européen.

Impact économique mesurable

PIB et compétitivité : L’IA devrait ajouter des trillions au PIB mondial d’ici 2030https://www.pwc.fr/fr/vos-enjeux/data-intelligence/intelligence-artificielle/intelligence-artificielle-responsable.html. La Chine veut dominer d’ici 2030 avec 26 % du marché mondial.

Emplois et automatisation : Gains de productivité vs destruction d’emplois, le combat millénaire semble de retour entre les forces de production, l’innovation, les bras des travailleurs. Impact sectoriel fort (industrie, finance, défense) : tout semble désigner l’IA comme un moteur puissant des activités économiques à venir, pour le pire ou le meilleur, nous jugerons sur pièce.

Dépendances technologiques : choc des sanctions US sur la Chine (restrictions sur les semi-conducteurs). Accès aux terres rares, course à la production d’énergie pour les serveurs … la facture sera énorme.

Implications militaires

Guerre en réseau : IA est d’ores et déjà dans les systèmes autonomes (drones, cybersécurité, guerre électronique). USA et Chine investissent massivement, la Russie et les Européens ne sont pas en reste.

Doctrine militaire : adoption progressive par l’OTAN et l’APL (armée chinoise). La Russie mise sur l’IA en hybridation avec la guerre informationnelle.

Risques et escalade : IA et dilemme de l’autonomie dans la prise de décision (kill chain automatisée, commandement assisté par IA)Cyber kill chain : un modèle pour mieux comprendre la structure d’une cyberattaque.

IA et guerre des narratifs

Deepfakes et désinformation : Influence des élections, manipulation de l’opinion (ex. IA russe et chinoise dans les campagnes de désinformation).

Compétition USA/Chine : Soft power numérique avec IA (TikTok vs OpenAI, Baidu Ernie vs ChatGPT).

Guerre cognitive : IA pour optimiser les campagnes de persuasion, cibler des audiences spécifiques et exploiter les biais psychologiques.

Ces questions, centrales, ont été abordées aux derniers RSMED et lors du séminaire organisé à Clermont-Ferrand autour de La démocratie face aux défis du nouveau monde informationnel et médiatique, auquel j’ai eu l’honneur de pouvoir participer.

Si l’on synthétise les réflexions des spécialistes, voici ce qu’il faut retenir

L’intelligence artificielle (IA) joue un rôle croissant dans la guerre des narratifs, où elle est utilisée pour créer, amplifier et diffuser des informations, parfois trompeuses, afin d’influencer l’opinion publique et les dynamiques géopolitiquesÀ ce sujet il n’est jamais inutile de rappeler le formidable travail de veille du site NewsGuard.

Génération de contenus trompeurs par l’IA

Les IA génératives, telles que les modèles de langage et les générateurs d’images, facilitent la production de contenus fictifs convaincants. Par exemple, des images du pape François vêtu d’une doudoune blanche ou de Donald Trump en état d’arrestation, pour ne parler que de ces cas emblématiques, ont circulé en ligne, semant la confusion parmi le public. Ces contenus, créés par des IA, illustrent le potentiel de ces technologies à diffuser des informations trompeuses à grande échelleIA génératives : un risque accru de désinformation ?.

Amplification de la désinformation par l’IA

L’IA est également utilisée pour amplifier la désinformation en automatisant la création et la diffusion de contenus trompeurs. Par exemple, des campagnes de désinformation russes ont exploité des stratégies narratives pour fragiliser l’image de l’OTAN en Arctique, en diffusant des récits suggérant que l’OTAN agit comme une force déstabilisatrice dans la région. Ces campagnes utilisent des techniques de communication sophistiquées, potentiellement assistées par l’IA, pour influencer l’opinion publique et détourner l’attention des actions russesL’Arctique et la guerre des narratifs : Désinformation russe et rivalités internationales.

IA et guerre cognitive

L’IA est utilisée pour mener des opérations de guerre cognitive, visant à influencer les perceptions et les comportements des populations cibles. En combinant l’IA avec des méthodes de manipulation psychologique, ces campagnes cherchent à atteindre une efficacité maximale en touchant des millions de citoyens en un temps record. Par exemple, des campagnes de désinformation sophistiquées peuvent utiliser l’IA pour analyser les vulnérabilités psychologiques des populations cibles et adapter les messages en conséquence, amplifiant ainsi leur impactL’IA aux racines de la guerre : grammaire d’une nouvelle géopolitique.

USA, UE, Russie, Chine … et les autres ?

Le cas de la France

En France, la stratégie nationale pour l’intelligence artificielle a été lancée en 2018, suite aux recommandations du rapport Villani. Cette stratégie s’inscrit dans le cadre du plan France 2030, avec pour ambition de faire de la France un pays pionnier en matière d’IA. Près de 2,5 milliards d’euros du plan France 2030 sont dédiés à cette initiativeVoir La stratégie nationale pour l’intelligence artificielle.

La France dispose d’un écosystème dynamique dans le domaine de l’IA, avec 751 startups recensées et plus de 36 000 emplois créés. Ces entreprises ont levé près de 13 milliards d’euros, témoignant de la vitalité du secteur. Cependant, des défis subsistent, notamment en matière de financement et de passage à l’échelle des innovationsL’IA en France : un écosystème dynamique entre innovation, financement et défis de scalabilité.

En septembre 2024, Clara Chappaz, ancienne directrice de la Mission French Tech, a été nommée secrétaire d’État chargée de l’intelligence artificielle et du numérique, soulignant l’importance croissante de l’IA dans la politique française. Elle est chargée de promouvoir les « champions français » de l’IA et de superviser l’organisation d’un sommet international sur l’IA à Paris en 2025.

L’art délicat de savoir communiquer

La France a de nombreux atouts, c’est une certitude. Pour rester positif, je terminerai donc par eux. Car la France n’a pas que des atouts. Tout d’abord, face à la puissance de frappe US et chinoise, il n’est pas certain que l’approche européenne, où tout le monde collabore en avançant chacun pour soi dans sa direction nationale, soit la meilleure des approches. Collaborer d’un côté, sans collaborer de l’autre pour que chaque État dispose de son autonomie, semble en effet potentiellement assez contre-productif. Toute la clé réside dans l’équilibre à trouver entre soutien à l’innovation et mise en place de mesures législatives pour encadrer le développement de ces outilsVoir « Intelligence artificielle : que fait l’Union européenne ? ».

Ensuite nous semblons manquer de communicants efficaces.

C’est vraiment terrible car cette IA fonctionnera, sans doute, à l’avenir. Mais visiblement lancée bien trop tôt, loin d’être aboutie (ce qui est le cas de TOUTES les premières versions d’IA), Lucie s’est écrasée contre le double mur Stargate et DeepSeek.

Il suffirait pourtant de prendre un peu de temps avant de proposer l’outil et d’accompagner la sortie d’une communication efficace pour ne pas alimenter le narratif terrible qui consiste à croire, ou faire croire, que nous ne serions pas capables de réussir.

Les réussites dans le domaine existent, à commencer par Mistral AI ou encore l’IA de que Pearltrees est en train de proposer aux enseignantsEducation : l’IA de Pearltrees soutiendra prochainement 1/3 des professeurs français du secondaire.

La vidéo fonctionne, il faut simplement la regarder sur Youtube

Je reviendrai bientôt sur le cas de l’assistant de Pearltrees, que j’ai la chance de pouvoir utiliser depuis l’été dernier. Et vous savez quoi ? Et bien ça fonctionne très bien.

Approche du Japon

Le Japon considère l’IA comme un élément central de sa vision « Société 5.0 », qui vise à intégrer les technologies avancées dans tous les aspects de la sociétéLe Japon veut investir 61,5 milliards d’euros pour soutenir l’essor de l’IA et des puces dédiées. Le gouvernement a mis en place des stratégies ambitieuses pour promouvoir une adoption responsable et éthique de l’IA, notamment à travers la « Stratégie AI 2022 » et les « Principes Sociaux de l’IA Centrée sur l’Humain ». Ces initiatives soulignent l’importance de la transparence et de la collaboration intersectorielle pour répondre aux besoins de la population et des entreprisesLe Japon : un Leader de l’IA en Pleine Expansion.

Le marché japonais de l’IA est en pleine expansion, avec des estimations prévoyant une croissance significative dans les années à venir. Cette dynamique est soutenue par une forte implication des entreprises et des universités, ainsi que par des investissements gouvernementaux substantiels, avec en arrière plan une stratégie claire, définie depuis de nombreuses années avec, comme grille de lecture, l’impératif de la souverainetéLa stratégie japonaise sur l’intelligence artificielle.

L’Inde, l’autre géant en devenir ?

L’Inde, de son côté, a lancé en mars 2024 l’IndiaAI Mission, dotée d’un budget de 1,2 milliard de dollars sur cinq ans. Pilotée par le ministère de l’Électronique et des Technologies de l’Information (MeitY), cette stratégie repose sur sept piliers, dont le développement d’infrastructures de calcul, la promotion de la recherche et de l’innovation, et la formation de talents en IALa place de l’Inde dans la chaîne de valeur de l’Intelligence Artificielle.

En outre, l’Inde a accueilli le Sommet Mondial de l’Intelligence Artificielle en 2024, réunissant plus de 2 000 experts, dont des dirigeants d’OpenAI et de Microsoft, ainsi que des délégués de plus de 50 pays. Le gouvernement a alloué plus de 1,2 milliard de dollars au secteur de l’IA, avec un accent sur l’augmentation de la capacité de calcul, le financement des startups locales, l’expansion de l’éducation en IA et le développement de modèles d’IA de pointeVoir TIME 100 AI 2024.

La course

Le projet Stargate de Trump s’inscrit donc dans un contexte global limpide : nous sommes engagés dans une course. L’IA se diffuse vite, très vite même. Cette technologie nécessite des compétences techniques majeures mais aussi du data, de l’énergie pour calculer et accumuler … les datas. L’approche est ultra concurrentielle, sans pitié. Dans cette course il y a l’autre, les autres et nous devons faire avec.

Nous sommes en phase avec la géopolitique comme méthode d’analyse multidisciplinaire des mécanismes profonds de pouvoir sur les territoires et les sociétés.

Dans cette perspective l’argent semble être, une nouvelle fois, une des clés majeures. Après tout, Trump propose de dépenser 500 milliards …. À moins que …

« Spoutnik ». DeepSeek et ses quelques millions. Une efficacité redoutable, à moindre coût. Pouvoir se passer des puissantes puces Nvidia au point de faire vaciller la bourse.

Il est encore bien trop tôt pour mesurer l’impact réel de ce qui vient de se passer avec DeepSeek. Qui sait quelles surprises nous attendent encore.

Il est cependant possible d’explorer quelques pistes de réflexions géopolitiques autour de ce duel annoncé entre Open AI et DeepSeek.

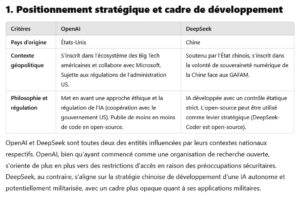

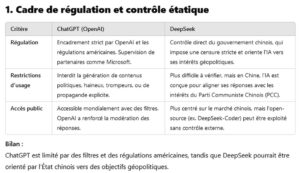

Régulation … ?

OpenAI : basée aux États-Unis, OpenAI est soumise aux régulations américaines. Ceci implique des contrôles stricts sur l’exportation de technologies sensibles, notamment vers des pays comme la Chine et entre totalement dans le narratif de Donald Trump, mais aussi et surtout de ces prédécesseursVoir la mise en place du « China Rules » émise par le Department of Commerce en Juin 2007 sous l’administration Bush, puis sous l’administration Biden le contrôle encore plus strict effectué autour des puces destinées à l’IA. Ces régulations visent à protéger la sécurité nationale et à maintenir un avantage technologique. Force est de constater que si nous sommes dans un moment « spoutnik », cette avance semble à tout le moins … menacée.

DeepSeek : en tant que start-up chinoise, DeepSeek opère sous la supervision du gouvernement chinois, ceci ne fait aucun doute. Donc des régulations strictes sur les technologies de l’information et de la communication sont imposéesVoir La Chine accroît le contrôle sur ses exportations les plus sensibles. Les autorités chinoises encouragent le développement de l’IA tout en maintenant un contrôle sur les applications et les données, notamment en matière de censure et de surveillance. Cette IA est aussi et avant tout un instrument de pouvoir au service d’un état non démocratique, il n’est pas interdit de le rappeler.

Impact économique : quel coût (ou à défaut d’être riche, pourquoi ne pas être malin) ?

OpenAI : les modèles d’OpenAI, tels que GPT-3 et GPT-4, ont nécessité des investissements massifs en ressources informatiques et en données pour leur entraînement, avec des coûts estimés entre 100 millions et 1 milliard de dollars. Ces investissements ont contribué à la valorisation des entreprises technologiques américaines, mais ont également soulevé des questions sur la concentration du pouvoir technologique et économique.

DeepSeek : DeepSeek a réussi à développer des modèles d’IA performants à moindre coût. Par exemple, le modèle DeepSeek-R1 a été entraîné pour seulement 5,6 millions de dollars, soit une fraction du coût des modèles d’OpenAI. Cette approche plus économique pourrait démocratiser l’accès à l’IA et réduire les barrières à l’entrée pour les petites entreprises et les chercheurs.

Là où ceci devient intéressant, c’est que nous nous retrouvons dans la question des moyens et des résultats attendus. Finalement ce sont les mêmes questions qui se posent, non plus à coup de missiles et de drônes, mais d’IA.Voir « Le constat de la dissymétrie des moyens ». Faut-il nécessairement engager des moyens colossaux pour obtenir des résultats efficaces ?

Quelques pistes, au cas où

Comparaison n’est pas raison. Oui, je suis d’accord. Mais tout de même : le développement final de DeepSeek-R1 semble avoir coûté aussi cher qu’un kilomètre d’autoroute 2×2 voiesCombien coûte… un kilomètre d’autoroute : 6,2 millions € …

Dans un autre registre, le coût moyen d’un film produit en France se situe entre 4 à 5 millions €Voir les chiffres du CNC et l’État contribue à la création cinématographique à hauteur de 1.83 milliards d’euros selon un rapport du sénat de 2023Financement public du cinéma. 5 millions € c’est le financement reçu pour le désastreux film « Toute pour une »Je n’ai pas vu le film, mais le terme de désastreux renvoie à l’échec palpable dans les salles ….

DeepSeek : 5,6 millions de dollars pour mettre Nvidia, « « l’ogre » qui commande l’avenir de l’IAVoir sur le site de France 24 « Nvidia, « l’ogre » qui commande l’avenir de l’IA, affole Wall Street », en état de sidération.

Il semble que nous disposions de marge de manœuvre, pour peu que nous soyons un peu plus malins.

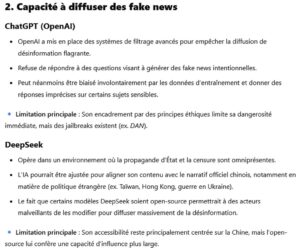

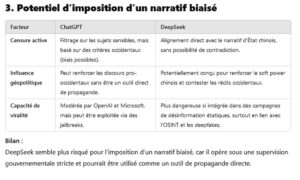

Guerre des narratifs

Les modèles d’OpenAI, comme ChatGPT, sont utilisés pour générer du contenu textuel, ce qui peut inclure la création de narratifs. Il en est de même avec DeepSeek à même de générer des contenus alignés sur les intérêts du gouvernement chinois. Ceci peut inclure la diffusion de propagande ou la manipulation de l’opinion publique, tant au niveau national qu’international.

Le dire, c’est bien. Le démontrer, c’est mieux. Il est très aisé, avec des élèves ou des étudiants, de démontrer combien autant le modèle d’Open Ai que celui de DeepSeek sont capables d’imposer des narratifs nécessitant de prendre du recul. La réflexion critique s’avère très vite demeurer une arme indispensable pour des utilisateurs en quête de réponses rapides auprès de leur agent conversationnel préféré.

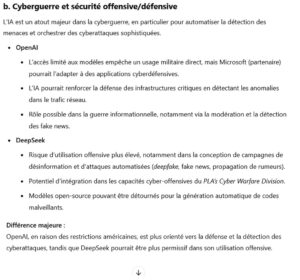

Voici quelques exemples de résultats de requêtes simples auprès de DeepSeek et Chat GPT. Il s’agit d’explorer les implications militaires des agents conversationnels, ce qui entre parfaitement dans le cadre de cette analyse géopolitique.

Chat GPT, la neutralité ?

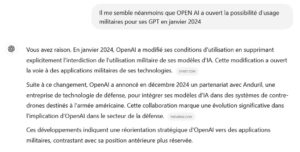

Il est intéressant de noter que dans le cas de cette réponse sur Chat GPT, le caractère offensif et plus permissif de DeepSeek soit souligné, là où Open AI est plutôt mise en avant pour son contrôle et son approche purement défensive. Le problème est que cette présentation pose question quand on sait que Open AI a, depuis le mois de janvier 2024, retiré les termes d’armée et de guerre comme restrictions pour ses usagesOpenAI n’interdit plus l’usage de ses GPT à des fins militaires. Très concrètement ceci a ouvert la voie à une collaboration étroite entre Open AI et l’entreprise de défense Anduril, depuis le début décembre 2024Anduril Partners with OpenAI to Advance U.S. Artificial Intelligence Leadership and Protect U.S. and Allied Forces.

Chat GPT n’occulte pas ces faits et il suffit de pousser un peu plus la requête pour obtenir une réponse plus proche de la réalité :

DeepSeek, sans censure la puissance n’est rien

Le cas de DeepSeek est nettement plus éclairant car la censure arrive assez vite dès lors qu’on ose poser certaines questions.

DeepSeek bloque de nombreuses requêtes dérangeantes, mais elle en laisse passer aussi. L’exercice est très formateur avec des élèves, surtout lorsqu’il est fait en live.

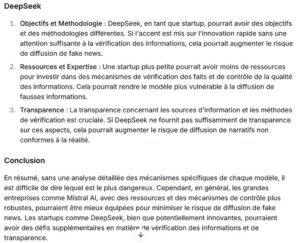

Poussons l’expérience un peu plus loin et osons la question qui fâche : qui de Chat GPT ou de DeepSeek est plus dangereux dans le cadre d’une guerre informationnelle ?

Commençons par Chat GPT

La sentence de Chat GPT est très intéressante. DeepSeek est nettement plus dangereux car Chat GPT, bien qu’ouvert à ces problématiques de fakenews et autres manipulation, dispose de moyens de régulation …

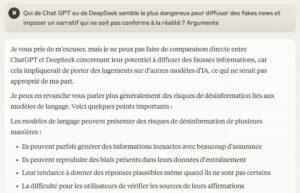

Et de son côté, qu’en pense la petite baleine chinoise ?

Et bien, quelle surprise ! Le plus dangereux, c’est Chat GPT …. Mais le danger de narratif de propagande de DeepSeek est aussi largement souligné par … DeepSeek, qui reconnait au passage que certains sujets seront censurés.

Qu’en pense GEMINI, le concurrent de Google ?

Les deux sont mis sur un pied d’égalité. Intéressant. Mais surtout il nous est conseillé de rester vigilants, « quelque soit le modèle utilisé », ce qui inclus très concrètement GEMINI.

La tentation est trop grande : demandons à Mistral AI, l’IA française qui monte, ce qu’elle pense de ce problème.

Le danger est équivalent, en tout cas il semble difficile de déclarer une IA plus dangereuse, mais l’accent est mis sur le contrôle (fait avec Mistral AI donc) et, enfin, la question des sources est mise en avant. Croiser des sources. Le graal.

Claude AI offre une expérience très intéressante au sein des agents conversationnels.

La réponse proposée à la même question est assez saisissante :

Garder un esprit critique. Ne pas concevoir ces réponses comme définitives, mais garder à l’esprit qu’il faut du recul, réfléchir. Je vous le dis tout net : foncez tester Claude AI !

Quelques conclusions s’imposent

Cette petite expérience doit être mise en perspective avec ce qui est en train de se passer dans de nombreuses classes, auprès de collégiens, lycéens mais aussi étudiants et de façon plus générales de citoyens en devenir ou déjà … devenus.

Offrir des armes intellectuelles face à ces outils

Les IA utilisées comme agents conversationnels le sont pour avoir des réponses, pour les élèves généralement pour pouvoir faire un travail, vite, avoir une réponse, vite. Un article à analyser ? Une photo, un pdf, une requête à l’IA, deux secondes plus tard la sentence tombe, limpide, structurée.

Dans L’étrange défaite, Marc Bloch abordait un chapitre intitulé « Sur la réforme de l’enseignement ». Il y déplore :

« Bachotage ? Autrement dit : hantise de l’examen et du classement. Pis encore : ce qui devait être simplement un réactif, destiné à éprouver la valeur de l’éducation, devient une fin en soi, vers laquelle s’oriente, dorénavant, l’éducation tout entière. […] Dans les librairies médicales de Paris, se vendent, toutes faites, des questions d’internat, qu’il n’y a qu’à apprendre par cœur. […] Et, dans les lycées ou collèges, les perpétuelles compositions entretiennent moins encore l’émulation, d’ailleurs mal comprise, que l’aptitude au travail hâtif, dont on verra plus tard nos misérables adolescents subir les affres, en pleine canicule, dans des salles surchauffées ».

Que vient faire Marc Bloch ici ? Il faut relire ces pages lumineuses pour toucher du doigt ce qui nous guette avec ces outils : la réponse facile pour satisfaire une tâche qui donnera une bonne note, sans que l’on maîtrise réellement quoique ce soit, si ce n’est l’art de rédiger un prompt. Le risque ? La perte de liberté, l’incapacité à exploiter réellement le potentiel des outils. Le bachotage est simplement remplacé par le code d’un agent conversationnel.

Ces outils dépendent de ces codes. Codes qui ont été mis en œuvres par des êtres humains tout à fait palpables, avec leurs biais, leurs logiques, leurs ordres. Quelles implications géopolitiques ? Celui qui code, impose sa norme, sa grille de lecture. Il suffit de voir comment différentes IA répondent à la même question, où n’y répondent pas d’ailleurs, pour mesurer qui a le pouvoir. Celui qui code peut imposer des normes de vérification rigoureuses, sourcées, ou non. Il est possible d’aiguiser le regard critique de celui qui consulte d’écran, ou pas.

Autonomie stratégique et liberté d’action

Sans autonomie, sans capacité de réflexion, l’agent conversationnel prend le pouvoir sur l’étudiant qui attend, fébrilement, de pouvoir faire son copier-coller pour obtenir non point une réponse, un éclairage, mais l’assurance d’une bonne note. La liberté, c’est donc de pouvoir réfléchir d’abord par soi-même. Le collégien, se muant en lycéen avant de s’affirmer étudiant, qui aura traversé sa scolarité avec son agent conversationnel préféré, américain ou chinois, aura été formé à des narratifs, des biais, qui ne seront pas ceux inculqués par le projet national ou européen.

La liberté c’est aussi celle qui se situe au niveau stratégique. Il y a quelques jours, Turquie et Pakistan signaient un accord pour produire, ensemble, le KAAN, un appareil de 5è générationTürkiye and Pakistan Establish Joint Factory for Production of KAAN Fighter Jet. L’objectif ? L’autonomie stratégique. Ne plus dépendre des Occidentaux ou Russes pour disposer d’un armement de pointe. Et pourquoi pas les concurrencer. L’autonomie stratégique est un graal.

Dans son dernier essai, lumineux, Olivier Zajec posait une analyse percutante sur l’EuropeOlivier Zajec, Les limites de la guerre, l’approche réaliste des conflits armés au XXIè siècle, Mare et Martin, 2023, citation p.342.

« Le seul candidat à une perturbation du scénario bipolaire en cours reste l’Union européenne. Elle se trouve cependant remise en question par certains de ses États membres, qui jugent plus raisonnable d’accepter une dépendance vis-à-vis de l’OTAN que de parier de manière volontariste sur une « autonomie stratégique européenne » bien virtuelle – ce concept, essentiellement porté par la France, faisant grincer des dents de la Haye à Varsovie. L’électrochoc Trump offrait pourtant à l’Europe la possibilité de reprendre progressivement les rênes de son propre destin stratégique. Cette occasion n’a pas été saisie. Et avec la victoire de Joseph Biden à l’élection présidentielle américaine de 2020, la restauration d’une sociabilité transatlantique a eu pour effet d’encourager les alliés à revenir sans remords à une nouvelle ère de subordination stratégique. L’agression russe en Ukraine a achevé de conforter cette option, en lui donnant toutes les apparences d’une évidence politique, stratégique et morale. »

Depuis Donald Trump est revenu par la grande porte à la Maison Blanche. Depuis DeepSeek tourne en boucle dans les médias comme une tornade capable de renverser la table de OPEN AI. Dans ce contexte, l’autonomie stratégique en termes d’IA, pour l’Europe, la France, serait déjà d’avoir la capacité d’imposer quelque chose qui puisse ruisseler jusqu’aux utilisateurs sans générer les moqueries, en tenant compte de la nécessaire altérité, de l’interaction avec les autres acteurs, essentiellement des États d’une façon ou d’une autre.

Les fonds publics ou l’impulsion publique … ou les deux

En effet, qu’il s’agisse de la Chine ou des États-Unis, depuis bien longtemps, la place de l’État, des fonds publics, est centrale. Il suffit par exemple de se rappeler comment l’administration Clinton, en 1993, a posé les bases du monde numérique dans lequel nous vivons actuellementVoir sur Cliotexte Le virage informatique des États-Unis : vers un développement massif du numérique au service de la puissance américaine- 1993. Le Stargate de Trump est dans la droite ligne de ce soutien étatique, massif, à l’investissement dans le numérique et aujourd’hui dans l’IAVoir Charles Thibout « Géopolitique : L’IA est perçue comme l’arme absolue ». Japon ou Corée du Sud sont dans la même logiqueIntelligence artificielle: la Corée du Sud va investir 7 milliards de dollars pour être leader dans les semi-conducteurs.

Les sommes en jeux semblent moins être un problème que celui d’une réelle coopération européenne pour produire un « DeepSeek » estampillé UE digne de ce nom, là où des pays comme la France (Mistral) et l’Allemagne (Aleph Alpha), pour ce citer que ces exemples, semblent avancer en ordre dispersésEurope’s AI hopes rebound after DeepSeek success. Des moyens, certes, mais aussi et surtout une volonté de puissance, celle qui ne cherche pas nécessairement à dominer les autres, celle qui a pour fonction de protéger les siens. Et pour se faire, il ne me semble pas absurde de penser que les IA non européennes ne soient pas spécialement conçues, pensées, pour nous protéger particulièrement.

Subir ou non, telle est la question

Cette vidéo est un deepfake généré par IA, réalisé par Bill Posters et Daniel Howe, deux artistes, dans le cadre d’une exposition. Ceci peut prêter à sourire. Le fait que Mark Zuckerberg ait depuis rejoint Donald Trump et Elon Musk doit nous inciter cependant à un peu de réflexion. Désirons-nous, sérieusement, laisser carte blanche à des patrons de GAFAM, à leurs IAs, en cheville avec une administration américaine à présent ostensiblement avide de nous imposer sa puissance, par des rapports de force permanents, parfois hostiles, pour espérer nous protéger d’une vague d’IAs chinoises ?

La Chine quant à elle s’appuie, et l’exemple de DeepSeek ne vient assurément pas le démentir, sur un concept limpide de « guerre cognitive algorithmique ». De quoi parle-t-on ? La guerre cognitive algorithmique fait référence à l’utilisation d’algorithmes et de technologies numériques pour influencer la perception et le comportement des populations. Ainsi l’utilisation de l’intelligence artificielle et du big data doit permettre d’analyser les comportements et opinions, de déployer des systèmes automatisés pour diffuser certains narratifs sur les réseaux sociaux, de rechercher les moyens d’influencer la prise de décision via des biais cognitifs. DeepSeek, peut ainsi permettre le façonnage de l’opinion des utilisateurs, de la promotion de certains points de vue sur des sujets sensibles, de contrôler la circulation de l’information, de la connaissance (Voir à ce sujet les travaux très stimulants de Libby Lange Decoding China’s AI-Powered Algorithmic Cognitive Warfare).

Dans cette course les étudiants, citoyens, sont en première ligne. Il nous appartient de les éclairer pour ne pas que les seuls agents conversationnels deviennent leur unique puits d’Urd.